今天的分享,我会以我比较尊敬的国平老师一篇和流量相关的文章作为引子,带你尝试深度阅读,发现文章背后的信息。

通过细节,挖掘信息背后的策略

文章中有这样一个信息是「让内容在搜索引擎喜欢的平台上流动」,我推测国平老师的想法是:

假设我挖掘到了关键字 A,那么我依据关键词 A 来做「满足用户搜索意图」的内容,可能是文章,可能是视频,可能是其他载体。再让这些内容在不同的自媒体号上传播。

上面这句话,总结一句话,就是关键字「找准」。

注意这里是「找准」,不是「找到」,这两者是有区别的,「找到」指的是你找到一个关键词,「找准」关键词指的你是找到了一个「有商业价值」的词。

然后把符合「关键词的用户搜索意图」的内容给整出来,多平台分发。各种自媒体号,各种音频号,各种视频号。

假设是按照关键字给你导流量,这个做的是哪些流量?一定要注意,是做百度的搜索流量,或者是可能各大平台的站内搜索流量。

核心指标是文章质量+文章数量(覆盖满足关键词数量的文章)。

很多团队都先以文章质量为第一指标,但我觉得弄错了。因为当你用关键词去覆盖更多的用户需求,一定是文章的 title 数量,视频的 title 数量在帮你抢流量。那么数量走在前面才是正确的。

那么做文章质量就错了吗?不对,我们需要有质量的文章获得流量渠道的曝光。如果内容做的好,才有可能做成爆款、跨圈层的文章。但为了获得有质量的文章,背后还隐藏了很多资源上的要求。

假如我财大气粗,那么就是用营销软文 + 派单的形式曝光;没预算的话,那就苦哈哈的想策略去商务层面的去曝光,或者是技术层面的曝光。

现在我们已经了解了一些策略,假设我落地执行,可能遇到哪些问题?

关键词词库 10 万起,需要生产的视频或文章内容最少也是万篇(可能是自动生成+小部分精品)吧?但文中并没有提及团队的人员规模配置,这就是可能遇到的第一个问题。

深度阅读一篇文章,还包括为可能存在的问题做好预案。通过我的思考,发现国平老师的文章非常适合大公司 —— 资源强、积累多的团队,跑起来会非常顺畅,会很快。

如果你使用了国平老师一样的方法,效果却没有那么好,就要考虑更多的隐含的因素,例如资源、钱、人员配比。

再往下推演,假设你真的搞出来了 10 万篇高质量的文章,第二个问题就是你如何分发。

我们假设用一个知乎号分发,平台安全风控值限制每天只能发布 10 篇,那么你需要 1 万天。而假设你有 1000 个知乎号。只要 10 天就完事了。

10万篇 = 1000个号 * 10 天 * 10篇/号/天。

而目前市场上自有 1000 个知乎高盐值号的团队,寥寥可数。

我们按照一个号 400 的成本去思考问题,那么你起步资金就是 40 万的账号成本,还不算内容的输出成本……这是一笔大开销。

假设你不用知乎,百家号,你用各种自媒体号,方法去计算是一样的。

只要你 ROI 控制的住,那么你就大胆的去测试,但是你当你用 1 个号,5 个号,10 个号,100 个号去测试的时候,你的成本模型会很不一样。

如果你根据文章的方法,不经思考判断直接落地执行,那么很可能还没有到 ROI 出来之前,就把钱花光了。

这个方法的优劣基本上都挖出来了,如果要落地,一定要评估下自己的基础条件。

这时我们再谈阅读文章这件事。读出来文章没有写明的东西本来就是很需要功力,而这种思维你需要长期训练,如果不训练就获取不到,训练的话,起码会慢慢变好。

上面仅是提及如何分发,生产内容的部分一笔带过了,我们再说下我如何从文章中挖掘内容生产相关的信息。

在国平老师的文章内,稍微提及了批量生产内容去 match 用户搜索意图这个动作。

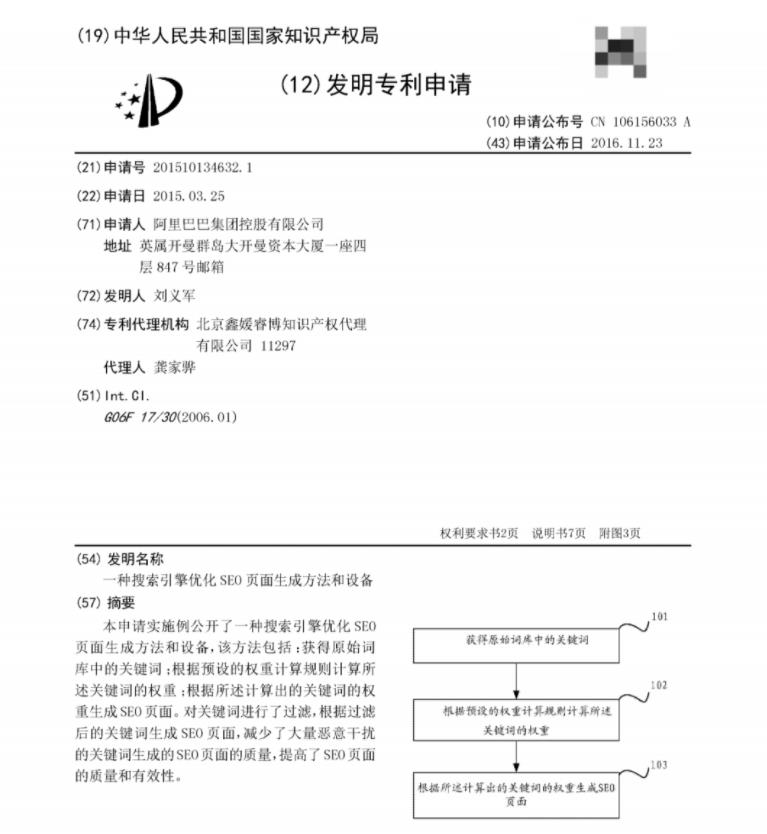

对此,我找到阿里巴巴的这一篇专利来对应国平老师的这篇文章,

文章中有以下的段落:

“以前这是我负责的,我能确定每个词每天的流量都达到了一定的搜索量,也就是说都是比较重要的词语。那时候我们的口头禅就是’加词等于加流量‘。记得当时从国外一家专门「卖词」的公司买了 3 万多个优质的词,然后我们一个季度的KPI就完成了。”

通过搜索,对应的专利可能就是这个。阿里巴巴曾经有一个专利,这个专利详细描述了,如何批量自动化生产页面,我想这个就是对应的国平老师的实践的总结,并且申请专利了,而且公开了。

很多优质的内容,真的需要我们好好深入的挖掘,才可以读懂作者的良苦用心。

本来只想讲分发,没有想到把内容生产部分也给讲出来了。

这份专利说到底就是一句话:提取关键词词库,根据规则,计算这个词的权重,最后去生产页面。

根据上下文,以及国平老师的文章,我们大胆推测这个权重可能牵扯到哪些规则:

1.当某个关键词的百度搜索量大于某个阈值,并且关键词不属于黑名单内,自动生成该关键字类型的页面

2.当某个关键词的域名的平均权重大于某个阈值,并且关键词不属于黑名单内,自动生成该关键字类型的页面

3.当某个关键词及其衍生关键词导入平台的量大于某个阈值,并且关键词不属于黑名单内,自动生成该关键字类型的页面

4.当某个关键词的站内搜索量大于某个阈值,并且关键词不属于黑名单内,自动生成该关键字类型的页面

5.当某个关键词的百度搜索量大于某个阈值,并且关键词不属于黑名单内,自动生成该关键字类型的页面

其中的 1、3、4 就是国平老师说的流量洼地的词汇。其中 2、5 就是 1688 的对应的优化的点。

挖掘出来了那么多词汇后,1688 是否会直接堆页面呢?不会。他肯定有某个策略,来执行哪些词先生成,哪些词慢生成。然后再把对应的文章类型跟上。

这个做法可以重点看看各大类型的 B2B 的站,基本上都是这个做法。但是策略的话,可能根据数据去做策略的制定。

到这里,咱们已经把第四个部分完整探讨了,也稍微提及文章生成、文章发布的坑和机会。

通过细节,发现信息背后的资源差距

那么下面继续阅读理解第六个部分:如何批量触达 KOL。

国平老师曾经讲过,我做 2C,去触达 1 个亿人,我要做 1 个亿的曝光。那么假设我去触达 100 个 100 万粉的 KOL,那么我只需要触达 100 个 KOL 即可。当我们把基数在降低下来,假设我们要触达 1000 个 10 万粉的,也有一个亿的曝光了。

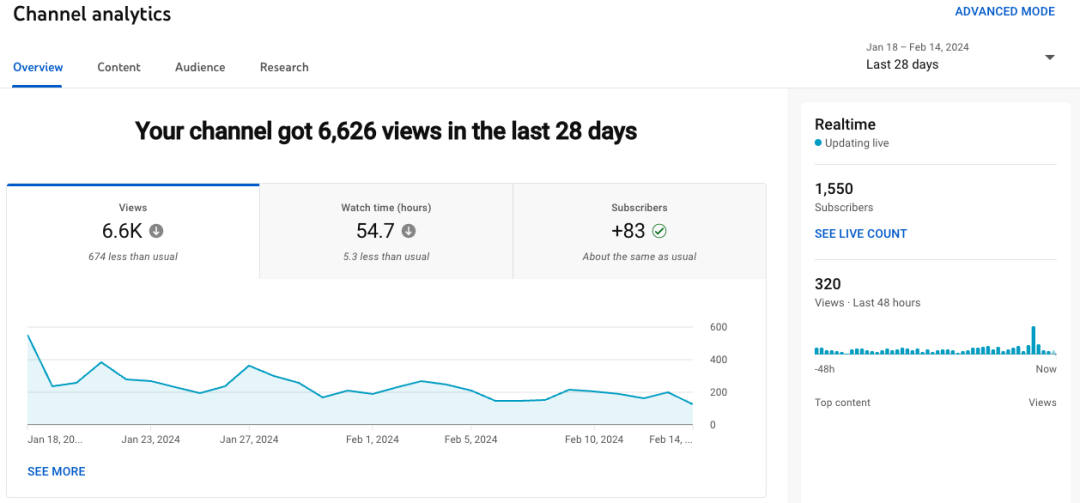

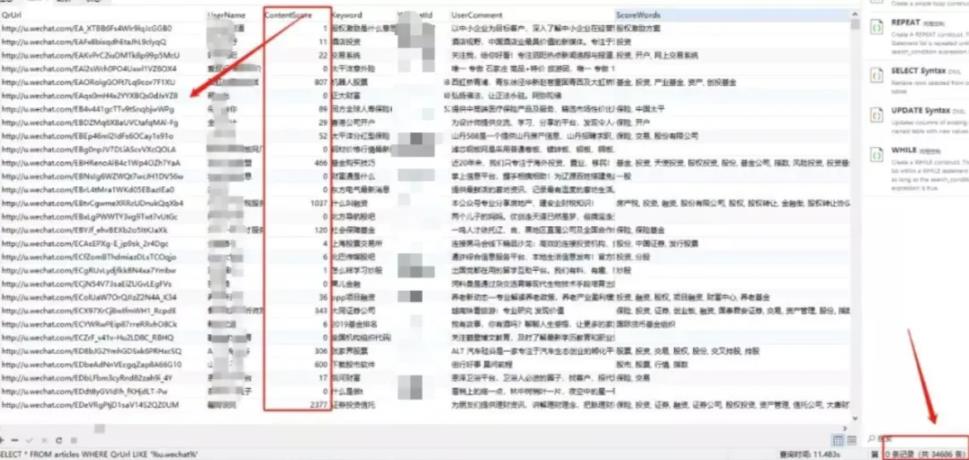

在国平老师的图片界面上,我们可以看到有采集的信息。再结合一些国平老师放出来的信息大胆推测,国平老师应该是采集了微信公众号,抖音,快手,微博,等各大平台的 KOL 的资料,进行二次数据分析,再用某些方式批量触达这群人。

这几年的互联网 APP 数据并未大开自由之门,通常都算逆向和反爬虫的斗争。那么假设国平老师需要做合规的采集任务,接下来也要招人,去解决通过技术获取数据的问题。果然,光年实验室的公众号上在之后推出了另一篇文章:

我们光年实验室招人了!

这就可以证实国平老师确实在招人,并且在推进这个事情。

其中岗位有:逆向工程师,和爬虫工程师。

那我们再一次推论,数据源大概率是通过这个环节来的。那么下一步就是如何批量触达 KOL。

通过光年实验室放出来的工具,我们再大胆推测,国平老师可能是用企业微信批量添加这些 KOL。

所有平台的账号,代理池,服务器,手机,人力……这些硬成本之下,我们还可以大致推演出来需要的资源、时间、人力等,绝非一个小数目。

这样深度阅读之后,我们可知与国平老师的差距不单单是一个文章的差距,还有资源上的压倒性差距。

总结

有些爽文案例是不适合读很多次的,因为仔细推演经不起推敲。请注意,我们的大脑有时候不是自己控制的大脑。

而生财的精华,基本上属于非常高质量的内容源了,很多人也喜欢打印出来多次阅读。当你需要精读某一篇的时候,可以按照我推演国平老师文章的这个做法,来深入挖掘文章背后的隐藏信息。

但显然我们与国平老师、或者很多精华作者的差距,不是一篇文章的差距;拆解国平老师的文章,我所能理解的可能仅是一种获取流量的方法而已,流量的世界如此庞杂,还有很多信息未经挖掘。

比如,如果要用跨圈层传播文章的套路,需要准备多大的启动量?当一篇文章被跨圈层传播的时候,你可以深入挖掘出一些种子量,是这些种子量致使文章跨圈传播的。

具体如何挖掘呢?看看哪个的发布时间早,哪个的阅读量大。

说点题外话。前些日子发生了很多事,很多事,心力憔悴,而生财始终会有一个氛围:始终有个人喊着你,坚持下,坚持下,快到了,熬下就好了。而这个氛围是别的社群不容易给到你的。

你在这里也可以找到很多的合作伙伴,这里涉猎了互联网非常多的行业,在这里学到应该学的东西,然后用到自己的主业。

当你向人请教的时候,如果彼此在做的事情不冲突,对方会乐意跟你多聊点。

感恩生活,感恩家人,感恩你的朋友圈。在赚钱这条路上,你并不孤独。